搜索到

296

篇与

的结果

-

![[MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕](https://www.vvars.com/usr/themes/Joe/assets/img/lazyload.jpg) [MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕 [MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕一直以来,林俊杰在音乐之旅上坚持用歌声带出能量,用音乐渲染世界,每个舞台都倾力发散光芒。而在林俊杰看来,舞台之所以发光,是因为听众在用心照亮他,每一束光线,都连结了彼此,成为专属的故事。在不同经历和时空下,和听众一起经历过的舞台,听过动容的歌曲,一定会在心中产生感喟,形成独一无二的珍贵记忆,也因此而心中有光,成为“心里裹着光的人”,于是他便创作了单曲《裹着心的光》,以此唱出心中最真挚的情感连结,感谢一路相伴的听众。一、歌曲简介《裹着心的光》是由林俊杰谱曲并演唱的歌曲,由易家扬作词,吴庆隆编曲,于2021年6月9日通过单曲形式发行。《裹着心的光》是为《林俊杰"圣所"世界巡回演唱会》做了一个璀璨的总结,这首歌包含了每个人独特的故事,拥有这些裹着亮光的心,《圣所》因此而变得完整。2023年7月8日,该曲获得第4届腾讯音乐娱乐盛典“年度十大金曲”奖。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-gzxdg.webm"/}三、解读感悟林俊杰的《裹着心的光》MV开场,镜头掠过城市夜晚:地铁站里疲惫的身影,便利店内独自用餐的店员,写字楼里加班的孤灯……这些画面如此熟悉,它们无声地描摹着现代人灵魂深处的孤岛状态。当JJ在录音室里疲惫地摘下耳机,屏幕上闪现歌迷们分享的暖心话语——这一刻,音乐与光影交织,揭示出歌曲最深刻的创作密码:在普遍孤独的时代里,每个人都是一座等待被点亮的灯塔。“光拿乌云揉成团,攥一把温暖”,歌词以惊人的通感将听觉的温暖转化成触觉的温度。光不再是虚无缥缈的意象,而是可以紧握在掌心、裹住心脏的真实存在。JJ用音乐将抽象的情感具象化,把无形的支持变成可触摸的暖流。那些“火把”、“萤火”、“星河”的意象层层递进,揭示出微光汇聚的磅礴力量——再微小的善意,也能在黑暗中凿开一道光的裂痕。MV中那些平凡却动人的瞬间:便利店店员默默为流浪者加热饭食,地铁里陌生人分享一副耳机,舞台上JJ与台下万千星光合唱……这些画面无声诉说着一个真理:光需要传递,温暖需要载体。每个人既是发光体,也是受光者。JJ创作这首歌,不只是单向的给予,更是对双向救赎的深刻理解——当他用歌声照亮歌迷时,歌迷眼中的星光同样温暖了他疲惫的创作灵魂。在舞台灯光与荧光棒的海洋里,JJ与歌迷完成了一场盛大的光之交响。这让我想起MV中那个震撼的航拍镜头:无数手机闪光灯在黑暗中连成一片流动的星河。原来最动人的光芒,并非来自遥不可及的太阳,而是由无数平凡灵魂的微光汇聚而成。当我们裹紧心中的光,便也成了照亮他人的光源。在这个被钢筋水泥和电子屏幕包裹的时代,孤独成为集体病症。《裹着心的光》如一剂温柔的解药,提醒我们:真正的光不在远方,而在我们相互靠近时摩擦产生的温度里。当无数微光相遇,便足以撕裂最厚重的黑暗幕布。不必等待救世主般的光芒普照大地——你递出的火把,我举起的烛光,就是刺破时代孤独最锋利的刃。你曾被哪束微光温暖过?四、歌曲歌词:光 拿乌云揉成团 像鲸鱼吻着浪 叫我 和你 去飞翔 人 老无语后落单 别跟丢了天空 沙滩 挣脱 回忆 壮胆 裹着心的光 很暖 与你 有关 有梦就听得到 用爱呼应感叹 心里裹着光 的人 世界 很宽 出发就走得到 来时路不会被 剪断 当 那无名领头羊 替明天找希望 说嘿 有我 别心慌 来 学萤火虫冥想 在昏暗中静默 发亮 是否 有梦 当然 裹着心的光 很响 说了 别慌 它说孤单很好 信念创造不凡 心里裹着光 的人 初衷 不换 誓言让心不老 带那些梦探索 远方 一路有雨 也有霜 月落无题江南 如我面对太阳 如你追希望 一诺冒险 就得闯 单板翻越冰川 未来不缺翅膀 冰雨和闷雷 别管 裹着心的光 很响 说了 别慌 它说孤单很好 信念创造不凡 心里裹着光 的人 初衷 不换 誓言让心不老 带那些梦探索 远方 问那些年的梦 有多烫

[MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕 [MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕一直以来,林俊杰在音乐之旅上坚持用歌声带出能量,用音乐渲染世界,每个舞台都倾力发散光芒。而在林俊杰看来,舞台之所以发光,是因为听众在用心照亮他,每一束光线,都连结了彼此,成为专属的故事。在不同经历和时空下,和听众一起经历过的舞台,听过动容的歌曲,一定会在心中产生感喟,形成独一无二的珍贵记忆,也因此而心中有光,成为“心里裹着光的人”,于是他便创作了单曲《裹着心的光》,以此唱出心中最真挚的情感连结,感谢一路相伴的听众。一、歌曲简介《裹着心的光》是由林俊杰谱曲并演唱的歌曲,由易家扬作词,吴庆隆编曲,于2021年6月9日通过单曲形式发行。《裹着心的光》是为《林俊杰"圣所"世界巡回演唱会》做了一个璀璨的总结,这首歌包含了每个人独特的故事,拥有这些裹着亮光的心,《圣所》因此而变得完整。2023年7月8日,该曲获得第4届腾讯音乐娱乐盛典“年度十大金曲”奖。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-gzxdg.webm"/}三、解读感悟林俊杰的《裹着心的光》MV开场,镜头掠过城市夜晚:地铁站里疲惫的身影,便利店内独自用餐的店员,写字楼里加班的孤灯……这些画面如此熟悉,它们无声地描摹着现代人灵魂深处的孤岛状态。当JJ在录音室里疲惫地摘下耳机,屏幕上闪现歌迷们分享的暖心话语——这一刻,音乐与光影交织,揭示出歌曲最深刻的创作密码:在普遍孤独的时代里,每个人都是一座等待被点亮的灯塔。“光拿乌云揉成团,攥一把温暖”,歌词以惊人的通感将听觉的温暖转化成触觉的温度。光不再是虚无缥缈的意象,而是可以紧握在掌心、裹住心脏的真实存在。JJ用音乐将抽象的情感具象化,把无形的支持变成可触摸的暖流。那些“火把”、“萤火”、“星河”的意象层层递进,揭示出微光汇聚的磅礴力量——再微小的善意,也能在黑暗中凿开一道光的裂痕。MV中那些平凡却动人的瞬间:便利店店员默默为流浪者加热饭食,地铁里陌生人分享一副耳机,舞台上JJ与台下万千星光合唱……这些画面无声诉说着一个真理:光需要传递,温暖需要载体。每个人既是发光体,也是受光者。JJ创作这首歌,不只是单向的给予,更是对双向救赎的深刻理解——当他用歌声照亮歌迷时,歌迷眼中的星光同样温暖了他疲惫的创作灵魂。在舞台灯光与荧光棒的海洋里,JJ与歌迷完成了一场盛大的光之交响。这让我想起MV中那个震撼的航拍镜头:无数手机闪光灯在黑暗中连成一片流动的星河。原来最动人的光芒,并非来自遥不可及的太阳,而是由无数平凡灵魂的微光汇聚而成。当我们裹紧心中的光,便也成了照亮他人的光源。在这个被钢筋水泥和电子屏幕包裹的时代,孤独成为集体病症。《裹着心的光》如一剂温柔的解药,提醒我们:真正的光不在远方,而在我们相互靠近时摩擦产生的温度里。当无数微光相遇,便足以撕裂最厚重的黑暗幕布。不必等待救世主般的光芒普照大地——你递出的火把,我举起的烛光,就是刺破时代孤独最锋利的刃。你曾被哪束微光温暖过?四、歌曲歌词:光 拿乌云揉成团 像鲸鱼吻着浪 叫我 和你 去飞翔 人 老无语后落单 别跟丢了天空 沙滩 挣脱 回忆 壮胆 裹着心的光 很暖 与你 有关 有梦就听得到 用爱呼应感叹 心里裹着光 的人 世界 很宽 出发就走得到 来时路不会被 剪断 当 那无名领头羊 替明天找希望 说嘿 有我 别心慌 来 学萤火虫冥想 在昏暗中静默 发亮 是否 有梦 当然 裹着心的光 很响 说了 别慌 它说孤单很好 信念创造不凡 心里裹着光 的人 初衷 不换 誓言让心不老 带那些梦探索 远方 一路有雨 也有霜 月落无题江南 如我面对太阳 如你追希望 一诺冒险 就得闯 单板翻越冰川 未来不缺翅膀 冰雨和闷雷 别管 裹着心的光 很响 说了 别慌 它说孤单很好 信念创造不凡 心里裹着光 的人 初衷 不换 誓言让心不老 带那些梦探索 远方 问那些年的梦 有多烫 -

![[MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气](https://www.vvars.com/usr/themes/Joe/assets/img/lazyload.jpg) [MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气 [MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气一、歌曲简介《日落》由张简君伟、邵豪Shao Hao、Nay Shalom宁夏作曲,小寒作词,由燕姿和音乐上的伙伴陈蔚甄共同担纲制作。歌词“视线以外 无形同载”,触动灵魂的深处,描绘了那些尽管在视线之外,却从未消失的情感,隐约却深刻,如是日落的余晖,共感而温暖着。渐进的琴键流畅进行,孙燕姿以她独有的声线层层堆叠循序展开,低沉缓慢到激昂高亢。歌曲以磅礴深刻的旋律诉说时间与自身的力量,是一首关于光与影,当下与奔赴的作品,也是对自我与生命的凝视。把生命中的每个日落串起,日落之前的灿烂,日落之后的勇气,一切都值得从零开始。《日落》是首关于光与影、当下与奔赴的作品,“日落以前没能相聚,那就日落以后极美欢庆”。2024年10月,孙燕姿时隔10年官宣回归开演唱会“就在日落之后”,这首歌和该演唱会主题相呼应。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-YanziSun-sunset.webm"/}三、解读感悟曾经的华语小天后,自2025年消失在大众视野后,蛰伏十年,为了她喜欢的歌唱和翘首以盼的歌迷,带着这首新发单曲《日落》归来。极具辨识度的嗓音,熟悉的燕式唱腔,随性率真的个性风格,都伴随着十年砺剑而丝毫未变,歌词中更有一种经历世事后的平静与坚持,燕姿——归来依旧是王者!《日落》里的孙燕姿,终于不再是我们记忆里那个奔跑在绿光之中的少女,时光无声流淌,如落霞沉淀为金。MV里的她安静伫立在巨大的夕阳之前,或是轻柔逆着人潮而行,步履平稳却意味深长,没有喧嚣的光环,没有刻意的高声宣告。是的,她在安静中返航了。但这场复出并非盛大的开幕式——她只是选择在一个安静的午后,缓缓地递来一首名为《日落》的曲子。在五年沉寂里,我们目睹无数“乘风破浪”的热闹场面,她却静守时光,只留一纸清冷的退隐宣言:“三年以后,也许我依然平凡”。当喧嚣的综艺舞台频频伸出橄榄枝,燕姿固执退场,如同一道无声拒绝的仪式。这并非逃避,是一种更深沉的自我守护,是在喧嚣中坚守内心的清醒澄澈。她在我们疾行的世间悄然调转方向——当所有人都在争前恐后奔跑时,她只身转身,缓缓走进那片夕阳余晖的从容里。这支MV的导演曾倾吐道:“日落,其实是白昼谢幕后一种深邃辽阔的姿态,亦是另一种光亮积蓄力量的方式。”《日落》所吟唱的,正是一种从容的告别美学。它告诉你:在追求速度的时代里,放缓脚步并非示弱,反而是一种精神贵族式的态度;隐退也并非陨落,那是为了积蓄照亮他人的温柔光芒重新返场。所以你看,孙燕姿的复出曲选择了“日落”这个意象——落日余晖下退去的白昼不是终结,它是积蓄的力量,是预告星光的信使;那份温柔平静不是消退的象征,却恰是灵魂苏醒之后的饱满与坚定。在这个总标榜“进步”的时代,真正的前行常藏匿于那些敢于“退”的优雅身影里,退,有时恰是更深的进。日落,是伪装温柔的曙光,更是星辰大海无声的回首宣言。当我们只懂得向“前”狂奔时,懂得适时停顿的人,才真正拥有了穿越长夜的星光导航。四、歌曲歌词:山 忽隐忽现 海市蜃楼是沙漠谎言 天 衔接水面 我的地平线越缩越远 我追 我推 我被 困在肢体范围 生活琐碎 捣碎 粉碎 是有或没 不再绝对 我在 日落到来 遥望太阳 潜入深海 等待 季节更改 年复一年 行程没改 尽管被夜取代 不表示光不存在 你的爱让我明白 视线之外 无形同载 星 眨眼瞬间 已经消失在千年以前 笑 挂在嘴边 喜悦却只是回忆重演 我追 我推 我退 不让躯体包围 开始理会 体会 领会 我将是谁 谁能答对 我在 日落到来 遥望太阳 潜入深海 等待 季节更改 年复一年 行程没改 尽管被夜取代 不表示光不存在 我感觉在醒过来 我在 日落到来 遥望恋人 潜入人海 等待 有天明白 我是爱情 这不会改 尽管不再倚赖 不表示爱不存在 我感觉在醒过来 视线之外 无形同载

[MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气 [MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气一、歌曲简介《日落》由张简君伟、邵豪Shao Hao、Nay Shalom宁夏作曲,小寒作词,由燕姿和音乐上的伙伴陈蔚甄共同担纲制作。歌词“视线以外 无形同载”,触动灵魂的深处,描绘了那些尽管在视线之外,却从未消失的情感,隐约却深刻,如是日落的余晖,共感而温暖着。渐进的琴键流畅进行,孙燕姿以她独有的声线层层堆叠循序展开,低沉缓慢到激昂高亢。歌曲以磅礴深刻的旋律诉说时间与自身的力量,是一首关于光与影,当下与奔赴的作品,也是对自我与生命的凝视。把生命中的每个日落串起,日落之前的灿烂,日落之后的勇气,一切都值得从零开始。《日落》是首关于光与影、当下与奔赴的作品,“日落以前没能相聚,那就日落以后极美欢庆”。2024年10月,孙燕姿时隔10年官宣回归开演唱会“就在日落之后”,这首歌和该演唱会主题相呼应。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-YanziSun-sunset.webm"/}三、解读感悟曾经的华语小天后,自2025年消失在大众视野后,蛰伏十年,为了她喜欢的歌唱和翘首以盼的歌迷,带着这首新发单曲《日落》归来。极具辨识度的嗓音,熟悉的燕式唱腔,随性率真的个性风格,都伴随着十年砺剑而丝毫未变,歌词中更有一种经历世事后的平静与坚持,燕姿——归来依旧是王者!《日落》里的孙燕姿,终于不再是我们记忆里那个奔跑在绿光之中的少女,时光无声流淌,如落霞沉淀为金。MV里的她安静伫立在巨大的夕阳之前,或是轻柔逆着人潮而行,步履平稳却意味深长,没有喧嚣的光环,没有刻意的高声宣告。是的,她在安静中返航了。但这场复出并非盛大的开幕式——她只是选择在一个安静的午后,缓缓地递来一首名为《日落》的曲子。在五年沉寂里,我们目睹无数“乘风破浪”的热闹场面,她却静守时光,只留一纸清冷的退隐宣言:“三年以后,也许我依然平凡”。当喧嚣的综艺舞台频频伸出橄榄枝,燕姿固执退场,如同一道无声拒绝的仪式。这并非逃避,是一种更深沉的自我守护,是在喧嚣中坚守内心的清醒澄澈。她在我们疾行的世间悄然调转方向——当所有人都在争前恐后奔跑时,她只身转身,缓缓走进那片夕阳余晖的从容里。这支MV的导演曾倾吐道:“日落,其实是白昼谢幕后一种深邃辽阔的姿态,亦是另一种光亮积蓄力量的方式。”《日落》所吟唱的,正是一种从容的告别美学。它告诉你:在追求速度的时代里,放缓脚步并非示弱,反而是一种精神贵族式的态度;隐退也并非陨落,那是为了积蓄照亮他人的温柔光芒重新返场。所以你看,孙燕姿的复出曲选择了“日落”这个意象——落日余晖下退去的白昼不是终结,它是积蓄的力量,是预告星光的信使;那份温柔平静不是消退的象征,却恰是灵魂苏醒之后的饱满与坚定。在这个总标榜“进步”的时代,真正的前行常藏匿于那些敢于“退”的优雅身影里,退,有时恰是更深的进。日落,是伪装温柔的曙光,更是星辰大海无声的回首宣言。当我们只懂得向“前”狂奔时,懂得适时停顿的人,才真正拥有了穿越长夜的星光导航。四、歌曲歌词:山 忽隐忽现 海市蜃楼是沙漠谎言 天 衔接水面 我的地平线越缩越远 我追 我推 我被 困在肢体范围 生活琐碎 捣碎 粉碎 是有或没 不再绝对 我在 日落到来 遥望太阳 潜入深海 等待 季节更改 年复一年 行程没改 尽管被夜取代 不表示光不存在 你的爱让我明白 视线之外 无形同载 星 眨眼瞬间 已经消失在千年以前 笑 挂在嘴边 喜悦却只是回忆重演 我追 我推 我退 不让躯体包围 开始理会 体会 领会 我将是谁 谁能答对 我在 日落到来 遥望太阳 潜入深海 等待 季节更改 年复一年 行程没改 尽管被夜取代 不表示光不存在 我感觉在醒过来 我在 日落到来 遥望恋人 潜入人海 等待 有天明白 我是爱情 这不会改 尽管不再倚赖 不表示爱不存在 我感觉在醒过来 视线之外 无形同载 -

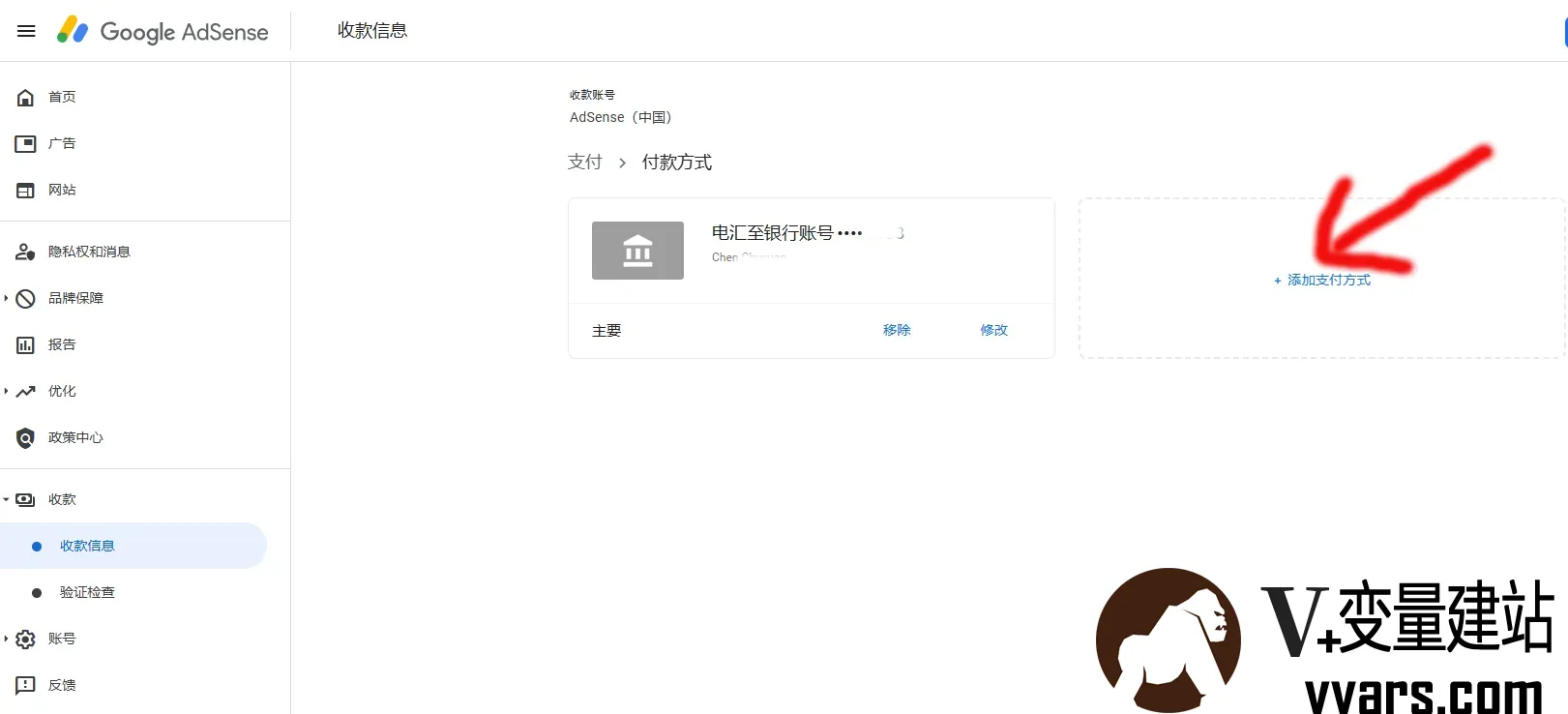

Google AdSense 国内提现教程:首选无手续费的招商银行 一.前言大家都知道,Google Adsense 在收益达到 100 美元后,便会自动使用电汇付款到绑定的银行卡。目前本站每天都有不到1美元的收益,日积月累,很快也到100美元的支付门槛了,但因为迟迟没有办理具有接受外汇的银行卡,导致推迟到现在才把这些流程搞定,而且收到了来自 Google Adsense 的首笔付款。今天就梳理一下我从办理银行卡到收到来自 Google Adsense 首笔打款的经历,同时也方便为自己做个记录,希望对大家有所帮助。二、adsense设置国内银行卡收款2.1 办理可以接收外汇的银行卡并非所有的银行卡均支持接受外汇,使用前请询问发卡地银行是否支持。关于手续费与合同的问题,我发现每个地方的政策都不一样。有些银行可能会存在手续费或是要求提供合同,有点麻烦。基于个人经验,本地的招商银行并未要求提供任何的合同也不存在任何的手续费用。这点,其实可以在询问银行卡能否接收外汇的时候一并问一下。 博主办理的是招行储蓄卡,因为免手续费,没有的小伙伴先申请一张招商银行一卡通。注意:银行卡必须为一类账户,二类及以下账户没有收款外币权限。开通网银和手机银行。招行的收款信息如下:收款行信息(招商银行总行) 银行名称(英文): China Merchants Bank 银行地址(英文):China Merchants Bank Tower NO.7088, Shennan Boulevard, Shenzhen, China 银行 SWIFT 代码: CMBCCNBS 收款人名称: 开户证件姓名的汉语拼音 收款人账号: 一卡通卡号2.2 填写 Adsense 付款方式登录 Google AdSense 管理后台点击 付款 > 付款信息 > 管理付款,添加付款方式。在付款页面可以根据下面信息来填写:付款人 ID(可选):不用填 银行账户上的姓名:Ma Baoguo(姓名拼音,大写,姓和名之间空格) 银行名称:China Merchants Bank(招行总行,不管哪个地方办理的卡都一样) SWIFT BIC:CMBCCNBS 账号:招商银行一卡通卡号 勾选设为主要付款方式 填写完成后,点击保存即可!2.3 等待AdSense 付款注意付款方式添加完成后并不会立刻就付款过来,需要等到余额达到 $100 后,谷歌 AdSense 固定在每个月 21 日(中国时间 22 日)发起付款,1-3 工作日可收到汇款。注意:一般来说 Google Adsense 款项在放款当天算起的 5 个工作日内会到达银行,银行再逐级向下放款,最终才会到达你的银行帐号。不要太着急,十来天到账也很正常。就像此次,我的收款正好赶上五一黄金周假期,假期肯定是没有办法到账,假期一过就到账了。三.招行 APP 结汇我们收到的汇款是美元,需要结汇成人民币,然后才能提现。下载安装登陆招商银行一卡通 APP,找到【外汇结汇】,点开后点击【去结汇】,在【结汇委托】界面:卖出货币:选择美元现汇 结汇资金来源:选择【其他经常转移】或【职工报酬和赡家款】 结汇金额:输入要结汇的金额 最后点击确定,输入密码即可成功结汇,结汇后的人民币就自动打入银行卡。另外需要注意每个人年度结汇总额度为 $50000,如果超出可到银行柜台申请额度。结汇业务办理时间是 8:30-22:00。到此为止,我们就可以通过 Google AdSense 赚取美元,然后结汇成人民币,最后提现到银行卡了。

Google AdSense 国内提现教程:首选无手续费的招商银行 一.前言大家都知道,Google Adsense 在收益达到 100 美元后,便会自动使用电汇付款到绑定的银行卡。目前本站每天都有不到1美元的收益,日积月累,很快也到100美元的支付门槛了,但因为迟迟没有办理具有接受外汇的银行卡,导致推迟到现在才把这些流程搞定,而且收到了来自 Google Adsense 的首笔付款。今天就梳理一下我从办理银行卡到收到来自 Google Adsense 首笔打款的经历,同时也方便为自己做个记录,希望对大家有所帮助。二、adsense设置国内银行卡收款2.1 办理可以接收外汇的银行卡并非所有的银行卡均支持接受外汇,使用前请询问发卡地银行是否支持。关于手续费与合同的问题,我发现每个地方的政策都不一样。有些银行可能会存在手续费或是要求提供合同,有点麻烦。基于个人经验,本地的招商银行并未要求提供任何的合同也不存在任何的手续费用。这点,其实可以在询问银行卡能否接收外汇的时候一并问一下。 博主办理的是招行储蓄卡,因为免手续费,没有的小伙伴先申请一张招商银行一卡通。注意:银行卡必须为一类账户,二类及以下账户没有收款外币权限。开通网银和手机银行。招行的收款信息如下:收款行信息(招商银行总行) 银行名称(英文): China Merchants Bank 银行地址(英文):China Merchants Bank Tower NO.7088, Shennan Boulevard, Shenzhen, China 银行 SWIFT 代码: CMBCCNBS 收款人名称: 开户证件姓名的汉语拼音 收款人账号: 一卡通卡号2.2 填写 Adsense 付款方式登录 Google AdSense 管理后台点击 付款 > 付款信息 > 管理付款,添加付款方式。在付款页面可以根据下面信息来填写:付款人 ID(可选):不用填 银行账户上的姓名:Ma Baoguo(姓名拼音,大写,姓和名之间空格) 银行名称:China Merchants Bank(招行总行,不管哪个地方办理的卡都一样) SWIFT BIC:CMBCCNBS 账号:招商银行一卡通卡号 勾选设为主要付款方式 填写完成后,点击保存即可!2.3 等待AdSense 付款注意付款方式添加完成后并不会立刻就付款过来,需要等到余额达到 $100 后,谷歌 AdSense 固定在每个月 21 日(中国时间 22 日)发起付款,1-3 工作日可收到汇款。注意:一般来说 Google Adsense 款项在放款当天算起的 5 个工作日内会到达银行,银行再逐级向下放款,最终才会到达你的银行帐号。不要太着急,十来天到账也很正常。就像此次,我的收款正好赶上五一黄金周假期,假期肯定是没有办法到账,假期一过就到账了。三.招行 APP 结汇我们收到的汇款是美元,需要结汇成人民币,然后才能提现。下载安装登陆招商银行一卡通 APP,找到【外汇结汇】,点开后点击【去结汇】,在【结汇委托】界面:卖出货币:选择美元现汇 结汇资金来源:选择【其他经常转移】或【职工报酬和赡家款】 结汇金额:输入要结汇的金额 最后点击确定,输入密码即可成功结汇,结汇后的人民币就自动打入银行卡。另外需要注意每个人年度结汇总额度为 $50000,如果超出可到银行柜台申请额度。结汇业务办理时间是 8:30-22:00。到此为止,我们就可以通过 Google AdSense 赚取美元,然后结汇成人民币,最后提现到银行卡了。 -

![[MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学](https://www.vvars.com/usr/themes/Joe/assets/img/lazyload.jpg) [MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学 [MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学一、歌曲简介《交换余生》是林俊杰演唱的歌曲,由易家扬作词,林俊杰作曲,简道生、蔡政勋编曲,于2020年9月16日以单曲形式发行,同年10月20日随音乐专辑《幸存者》在数字音乐平台发行。《交换余生》是迷你音乐专辑《幸存者》的首波前导单曲,林俊杰希望通过该歌曲写出不同的生命故事,将每个生命的瞬间组成每个可能。该歌曲的整体风格旋律婉转柔美,情绪起伏逐步递进,歌词充满着宿命感的羁绊,让听众跟随一起反思人生。2020年,林俊杰凭借该曲入围亚洲流行音乐大奖“最佳华语作曲人奖”,该歌曲则入围“年度华语歌曲奖” 。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-jhys.webm"/}三、解读感悟教室黑板上的量子方程尚未擦净,林俊杰已用钢琴声震碎了时空的玻璃幕墙。《交换余生》MV里漂浮的克莱因蓝沙漏,盛着的不仅是流动的时光碎屑,更是现代人渴望重写命运的集体执念。那些在走廊反复交错的透明雨伞,暗合了量子物理中"观测即坍塌"的玄妙定律。当女主角在三个平行时空分别扮演学生、病患与幸存者,我们突然惊觉:每个时间线里飘落的银杏叶,都带着宿命论的独特叶脉。导演用0.7倍速拍摄的雨中回眸,恰似薛定谔的猫在生死叠加态中凝视观众——那些未发生的可能,反而构成了爱情最真实的重量。林俊杰在副歌部分刻意模糊的转调处理,像极了平行时空相互渗透的引力波纹。当C大调与降E小调在弦乐中量子纠缠,我们听见宿命在琴键上坍缩成既定现实的声响。特别值得玩味的是MV中反复出现的医院长廊,既是生与死的临界通道,也是不同时间线自我修正的莫比乌斯环——那些被折叠的抉择,终会在某个时空的奇点重新展开。在这个用社交账号切换多重人格的时代,《交换余生》撕开了现代人深藏的集体潜意识:我们何尝不是在无数平行账号里扮演着理想自我?当林俊杰在废墟中弹响最后的重音,那些散落在量子云端的可能性碎片,终将聚合成完整的生命光谱。或许真正的永恒,不在于改写过去,而在于让每个当下都成为平行宇宙的黄金支点。四、歌曲歌词:孤单听雨的猫 往时间裂缝里看到了我 雷电交加之外的另一些我 乌云静止以后 跳进平行时空 那些我 旅行中的你我 回忆胡乱穿梭 坠落 交换余生 是我 非我 苦与乐 阴天之后总有续命的晴空 如果我们几经转折 结局一样不动 也才算无愧这分合 定位心海的锚 让时间停顿得像慢动作 你说命运很坏吧幸好有我 如果没有以后 如果平行失控 那些我 不同人生的我 会以什么方式 哭过 交换余生 是我 非我 苦与乐 阴天之后总有续命的晴空 如果我们几经转折 结局一样不动 也才算无愧这分合 云等风 人等梦 爱辗过时光等什么 记不住 认不出 泪眼中谁一样脸红 等你说 等我说 一等就是一个宇宙 日升换月落 真爱换寂寞 交换余生 也许 忘了 第几梦 那时我们身处第几号时空 因为我们手心紧握 记忆也能紧扣 可不怕前方的虫洞 爱是时间的古董

[MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学 [MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学一、歌曲简介《交换余生》是林俊杰演唱的歌曲,由易家扬作词,林俊杰作曲,简道生、蔡政勋编曲,于2020年9月16日以单曲形式发行,同年10月20日随音乐专辑《幸存者》在数字音乐平台发行。《交换余生》是迷你音乐专辑《幸存者》的首波前导单曲,林俊杰希望通过该歌曲写出不同的生命故事,将每个生命的瞬间组成每个可能。该歌曲的整体风格旋律婉转柔美,情绪起伏逐步递进,歌词充满着宿命感的羁绊,让听众跟随一起反思人生。2020年,林俊杰凭借该曲入围亚洲流行音乐大奖“最佳华语作曲人奖”,该歌曲则入围“年度华语歌曲奖” 。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-jhys.webm"/}三、解读感悟教室黑板上的量子方程尚未擦净,林俊杰已用钢琴声震碎了时空的玻璃幕墙。《交换余生》MV里漂浮的克莱因蓝沙漏,盛着的不仅是流动的时光碎屑,更是现代人渴望重写命运的集体执念。那些在走廊反复交错的透明雨伞,暗合了量子物理中"观测即坍塌"的玄妙定律。当女主角在三个平行时空分别扮演学生、病患与幸存者,我们突然惊觉:每个时间线里飘落的银杏叶,都带着宿命论的独特叶脉。导演用0.7倍速拍摄的雨中回眸,恰似薛定谔的猫在生死叠加态中凝视观众——那些未发生的可能,反而构成了爱情最真实的重量。林俊杰在副歌部分刻意模糊的转调处理,像极了平行时空相互渗透的引力波纹。当C大调与降E小调在弦乐中量子纠缠,我们听见宿命在琴键上坍缩成既定现实的声响。特别值得玩味的是MV中反复出现的医院长廊,既是生与死的临界通道,也是不同时间线自我修正的莫比乌斯环——那些被折叠的抉择,终会在某个时空的奇点重新展开。在这个用社交账号切换多重人格的时代,《交换余生》撕开了现代人深藏的集体潜意识:我们何尝不是在无数平行账号里扮演着理想自我?当林俊杰在废墟中弹响最后的重音,那些散落在量子云端的可能性碎片,终将聚合成完整的生命光谱。或许真正的永恒,不在于改写过去,而在于让每个当下都成为平行宇宙的黄金支点。四、歌曲歌词:孤单听雨的猫 往时间裂缝里看到了我 雷电交加之外的另一些我 乌云静止以后 跳进平行时空 那些我 旅行中的你我 回忆胡乱穿梭 坠落 交换余生 是我 非我 苦与乐 阴天之后总有续命的晴空 如果我们几经转折 结局一样不动 也才算无愧这分合 定位心海的锚 让时间停顿得像慢动作 你说命运很坏吧幸好有我 如果没有以后 如果平行失控 那些我 不同人生的我 会以什么方式 哭过 交换余生 是我 非我 苦与乐 阴天之后总有续命的晴空 如果我们几经转折 结局一样不动 也才算无愧这分合 云等风 人等梦 爱辗过时光等什么 记不住 认不出 泪眼中谁一样脸红 等你说 等我说 一等就是一个宇宙 日升换月落 真爱换寂寞 交换余生 也许 忘了 第几梦 那时我们身处第几号时空 因为我们手心紧握 记忆也能紧扣 可不怕前方的虫洞 爱是时间的古董 -

![[MV]-林俊杰-可惜没如果——当琴键悬停于半空:重读《可惜没如果》的未完成美学](https://www.vvars.com/usr/themes/Joe/assets/img/lazyload.jpg) [MV]-林俊杰-可惜没如果——当琴键悬停于半空:重读《可惜没如果》的未完成美学 当琴键悬停于半空:重读《可惜没如果》的未完成美学一、歌曲简介歌曲《可惜没如果》,由林俊杰作曲并演唱,林夕作词,蔡政勋编曲,收录在林俊杰第11张个人专辑《新地球GENESIS》中,是专辑的首波抒情主打,同时也是韩剧《杜鹃之巢》的中文主题曲、《对我而言,可爱的她》的中文片尾曲。该歌曲于2014年12月19日首发开始蝉联QQ音乐流行指数第一名长达两周,并获得多个榜单冠军,及音乐风云榜、中国TOP排行榜等多项金曲奖,MV还入选2014年12月台湾五大精选行销类微电影。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-kxmrg.webm"/}三、解读感悟深夜重看《可惜没如果》MV时,目光总被那个悬而未决的钢琴键定格——Angelababy指尖即将触键的瞬间,像被时光凝固的琥珀。这种"未完成"的叙事美学,恰是林俊杰音乐中最高明的留白。MV里穿着海军制服的男女主角,在虚实交织的时空中反复错过。餐桌上的烛光明明灭灭,钢琴教室的尘埃在光束里沉浮,所有细节都在暗示:这不是简单的校园纯爱故事。当男主角在战场硝烟中抚摸着泛黄照片,我们突然意识到,那些被反复擦写的记忆片段,或许只是幸存者用悔恨编织的平行时空。林俊杰的钢琴旋律始终在降B大调与C小调间游移,如同MV中不断切换的冷暖色调。这种音乐与视觉的互文,将"如果"的假设性演绎得淋漓尽致。Angelababy始终没有按下的琴键,正是对"未选择之路"最诗意的隐喻——每个岔路口的迟疑,都让回忆在反刍中愈发完美。现代人总在社交媒体追逐"无悔人生"的幻影,却不知真正的遗憾美学恰恰藏在那些未完成的瞬间。就像MV里永远差半步的拥抱,那些悬停在半空中的选择,反而构成了生命的张力。当我们停止用"本可以"苛责自己,那些未竟的琴音,终将在时光长河里谱成独特的生命韵律。四、歌曲歌词:假如把犯得起的错 能错的都错过 应该还来得及去悔过 假如没把一切说破 那一场小风波 将一笑带过 在感情面前 讲什么自我 要得过且过 才好过 全都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 只剩下结果 如果早点了解 那率性的你 或者晚一点 遇上成熟的我 不过 oh 全都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 没有你和我 都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 只剩下结果 可惜没如果

[MV]-林俊杰-可惜没如果——当琴键悬停于半空:重读《可惜没如果》的未完成美学 当琴键悬停于半空:重读《可惜没如果》的未完成美学一、歌曲简介歌曲《可惜没如果》,由林俊杰作曲并演唱,林夕作词,蔡政勋编曲,收录在林俊杰第11张个人专辑《新地球GENESIS》中,是专辑的首波抒情主打,同时也是韩剧《杜鹃之巢》的中文主题曲、《对我而言,可爱的她》的中文片尾曲。该歌曲于2014年12月19日首发开始蝉联QQ音乐流行指数第一名长达两周,并获得多个榜单冠军,及音乐风云榜、中国TOP排行榜等多项金曲奖,MV还入选2014年12月台湾五大精选行销类微电影。二、MV欣赏{dplayer src="https://www.vvars.com/tools/mv/MV-JJLin-kxmrg.webm"/}三、解读感悟深夜重看《可惜没如果》MV时,目光总被那个悬而未决的钢琴键定格——Angelababy指尖即将触键的瞬间,像被时光凝固的琥珀。这种"未完成"的叙事美学,恰是林俊杰音乐中最高明的留白。MV里穿着海军制服的男女主角,在虚实交织的时空中反复错过。餐桌上的烛光明明灭灭,钢琴教室的尘埃在光束里沉浮,所有细节都在暗示:这不是简单的校园纯爱故事。当男主角在战场硝烟中抚摸着泛黄照片,我们突然意识到,那些被反复擦写的记忆片段,或许只是幸存者用悔恨编织的平行时空。林俊杰的钢琴旋律始终在降B大调与C小调间游移,如同MV中不断切换的冷暖色调。这种音乐与视觉的互文,将"如果"的假设性演绎得淋漓尽致。Angelababy始终没有按下的琴键,正是对"未选择之路"最诗意的隐喻——每个岔路口的迟疑,都让回忆在反刍中愈发完美。现代人总在社交媒体追逐"无悔人生"的幻影,却不知真正的遗憾美学恰恰藏在那些未完成的瞬间。就像MV里永远差半步的拥抱,那些悬停在半空中的选择,反而构成了生命的张力。当我们停止用"本可以"苛责自己,那些未竟的琴音,终将在时光长河里谱成独特的生命韵律。四、歌曲歌词:假如把犯得起的错 能错的都错过 应该还来得及去悔过 假如没把一切说破 那一场小风波 将一笑带过 在感情面前 讲什么自我 要得过且过 才好过 全都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 只剩下结果 如果早点了解 那率性的你 或者晚一点 遇上成熟的我 不过 oh 全都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 没有你和我 都怪我 不该沉默时沉默 该勇敢时软弱 如果不是我 误会自己洒脱 让我们难过 可当初的你 和现在的我 假如重来过 倘若那天 把该说的话好好说 该体谅的不执着 如果那天我 不受情绪挑拨 你会怎么做 那么多如果 可能如果我 可惜没如果 只剩下结果 可惜没如果 -

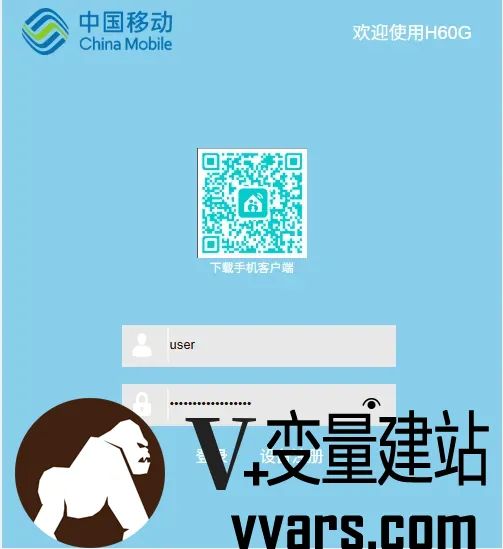

中国移动H60G光猫修改超级管理员密码 中国移动的光猫H60G是一款支持光纤接入的调制解调器(光猫),通常用于家庭宽带网络的接入和路由功能。本文介绍了如何修改移动光猫H60G修改光猫超级管理员密码。一、基础信息型号: H60G(中国移动定制版)接口类型: 通常包含光纤接口(PON)、千兆LAN口、电话接口(VoIP)、USB接口等。功能: 支持光纤转WiFi/有线网络、IPTV、VoIP电话等。默认管理地址: 192.168.1.1 或 192.168.0.1默认登录账号密码:普通用户:user / 密码见设备背面标签。超级管理员(需谨慎操作):CMCCAdmin / 密码可能为 aDm8H%MdA 或随机生成(需联系移动客服获取)。二、修改光猫超级管理员密码1、先登录光猫后台用普通用户先进去(账号密码在光猫背面用户名一般为:user),然后点网络--远程管理--Password 把密码记录好等会用到另外还需要记住宽带账号和密码(如果不需要改桥接 就不用记)不知道密码的可以发送短信CZKDMM到10086重置密码2、恢复出厂设置拔掉光纤,拿牙签捅光猫后面的reset孔,不要松掉,看光猫表面,绿灯全亮一次(不能松),等待几秒后绿灯全亮两次后松开(此款光猫就是这样,一共亮三次后才算完全恢复出厂设置,一次是重置而已)。电脑用网线直连光猫LAN口(因为此款光猫无wifi)。3、使用移动默认超级用户登录账号:CMCCAdmin密码:aDm8H%MdA建议用复制,区分大小写。登录后别急着操作,点击--安全--telnet配置--勾选启用WAN侧telnet--勾选启用LAN侧telnet--记录下用户名、密码(也可自定义,我这里用默认的),点击确定。如下图:4、操作光猫下发数据右上角退出登录--插上光纤--选择设备注册--输入第一步记录下的password值--下发数据,(因为我已经注册,截不到图,哈哈哈)5.Telnet登录光猫等待下发数据完成,管理员密码自然变成随机了,用默认超级用户肯定进不去,这时候我们走telnet操作。开始--运行(没有就Windows键+R)--cmd--弹出命令行窗口--输入:telnet 192.168.1.1(回车)(出现telnet不是内部或外部命令的,自己手机百度下怎么开启telnet客户端,小白操作经常问这个问题)输入telnet用户名(3记录的)(回车)--输入密码(第四步记录的,输入的时候不会显示的)(回车)--标识符变成“~$”了输入:su(回车)--输入密码(这时候的密码就是移动本身超级用户的密码:aDm8H%MdA,输入时还是不显示,特别注意大小写,注意大小写,注意大小写!!!说三遍,因为不会显示,很多输入不成功的)(回车)--标识符变成“/#”--这时候就提权成功了6.修改超级管理员密码修改管理员超级账号的密码 aDm8H%MdA (可自定义)sidbg 1 DB set DevAuthInfo 0 Pass aDm8H%MdA如果下次登录的时候提示密码错误 可能密码被远程重置了 可以再次进入telnel重置密码就行

中国移动H60G光猫修改超级管理员密码 中国移动的光猫H60G是一款支持光纤接入的调制解调器(光猫),通常用于家庭宽带网络的接入和路由功能。本文介绍了如何修改移动光猫H60G修改光猫超级管理员密码。一、基础信息型号: H60G(中国移动定制版)接口类型: 通常包含光纤接口(PON)、千兆LAN口、电话接口(VoIP)、USB接口等。功能: 支持光纤转WiFi/有线网络、IPTV、VoIP电话等。默认管理地址: 192.168.1.1 或 192.168.0.1默认登录账号密码:普通用户:user / 密码见设备背面标签。超级管理员(需谨慎操作):CMCCAdmin / 密码可能为 aDm8H%MdA 或随机生成(需联系移动客服获取)。二、修改光猫超级管理员密码1、先登录光猫后台用普通用户先进去(账号密码在光猫背面用户名一般为:user),然后点网络--远程管理--Password 把密码记录好等会用到另外还需要记住宽带账号和密码(如果不需要改桥接 就不用记)不知道密码的可以发送短信CZKDMM到10086重置密码2、恢复出厂设置拔掉光纤,拿牙签捅光猫后面的reset孔,不要松掉,看光猫表面,绿灯全亮一次(不能松),等待几秒后绿灯全亮两次后松开(此款光猫就是这样,一共亮三次后才算完全恢复出厂设置,一次是重置而已)。电脑用网线直连光猫LAN口(因为此款光猫无wifi)。3、使用移动默认超级用户登录账号:CMCCAdmin密码:aDm8H%MdA建议用复制,区分大小写。登录后别急着操作,点击--安全--telnet配置--勾选启用WAN侧telnet--勾选启用LAN侧telnet--记录下用户名、密码(也可自定义,我这里用默认的),点击确定。如下图:4、操作光猫下发数据右上角退出登录--插上光纤--选择设备注册--输入第一步记录下的password值--下发数据,(因为我已经注册,截不到图,哈哈哈)5.Telnet登录光猫等待下发数据完成,管理员密码自然变成随机了,用默认超级用户肯定进不去,这时候我们走telnet操作。开始--运行(没有就Windows键+R)--cmd--弹出命令行窗口--输入:telnet 192.168.1.1(回车)(出现telnet不是内部或外部命令的,自己手机百度下怎么开启telnet客户端,小白操作经常问这个问题)输入telnet用户名(3记录的)(回车)--输入密码(第四步记录的,输入的时候不会显示的)(回车)--标识符变成“~$”了输入:su(回车)--输入密码(这时候的密码就是移动本身超级用户的密码:aDm8H%MdA,输入时还是不显示,特别注意大小写,注意大小写,注意大小写!!!说三遍,因为不会显示,很多输入不成功的)(回车)--标识符变成“/#”--这时候就提权成功了6.修改超级管理员密码修改管理员超级账号的密码 aDm8H%MdA (可自定义)sidbg 1 DB set DevAuthInfo 0 Pass aDm8H%MdA如果下次登录的时候提示密码错误 可能密码被远程重置了 可以再次进入telnel重置密码就行 -

通过1panel使用docker部署bitwarden并配置mysql数据库和CDN加速以及自动化备份教程 在此之前你需要准备:聪明的脑子,灵活的手 ,友善的嘴巴,认真的耳朵。废话不多说我们开始吧!一、环境准备与1Panel安装1.服务要求推荐系统:Ubuntu/debian(务必使用最新的系统,不建议使用Centos)硬件配置:1核CPU以上、2GB内存、20GB存储(支持轻量级MySQL运行)域名:需要自己的独立域名,可选是否备案(用于HTTPS证书申请和CDN加速)2.开始搭建首先通过你能想象到的一切方法打开你购买的服务器ssh终端连接然后输入以下命令Ubtnuncurl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sudo bash quick_start.shDebiancurl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && bash quick_start.sh一路回车最后记录下ssh终端打印的1panel信息(外网/内网连接地址,用户名和密码),浏览器打开服务器的1panel网页管理地址登录到1panel管理面板后恭喜你已经完成了第一小步子 xhj016二.部署bitwarden前的准备1.登入1panel后找到侧边栏选择应用商店并打开选择安装如下软件1)mysql(数据库,最新版本即可)2)OpenResty(web平台,用于反向代理bitwarden到外网)这两个软件直接点击搜索然后一键安装即可2.创建一个mysql数据库点开1panel侧边栏的数据库按钮跳转的数据库页面后请按照如下配置创建数据库: 数据库名称(自定义) 数据库用户名(自定义) 数据库密码(自定义,建议使用复杂密码) 权限(所有人%)确定配置后点击确认即可3.创建一个网站用于反向代理bitwarden服务点开1panel侧边栏的网站按钮>网站选项跳转网站管理页面后请按照如下配置创建反向代理网站网站类型(反向代理) 分组(默认) 主域名(你为bitwarden准备的专用域名) 其他域名(默认不写) 监听IPV6(可选可不选) 代号(同网站目录地址,默认即可) 代理地址(填写bitwarden服务地址端口,本篇教程为http://127.0.0.1:8080)三.开始部署bitwarden1.打开1panel的应用商店搜索Bitwarden2.点击安装(请按照如下要求配置)名称(随意,推荐使用Bitwarden,BitwardenServer,Vaultwarden,VaultwardenServer等名字) 版本(默认即可,后续会通过自定义 compose修改安装版本) 端口(这里使用8080) 高级设置(这里要开启) 容器名字(与第一个配置“名称”一样即可) 端口外部访问(这里不要开) CPU限制(默认即可) 内存限制(默认即可) 编辑 compose文件(这里要开启) 拉取镜像(开启)3.自定义 compose配置networks: 1panel-network: external: true # 定义服务列表 services: # 服务名称:vaultwarden(Bitwarden 密码管理器的 Rust 实现) vaultwarden: # 指定容器名称(使用环境变量 CONTAINER_NAME 的值) container_name: ${CONTAINER_NAME} # 部署配置(通常用于 Docker Swarm,但单机模式也可识别) deploy: # 资源限制配置 resources: limits: # 限制 CPU 核数(使用环境变量 CPUS 的值) cpus: ${CPUS} # 限制内存使用量(使用环境变量 MEMORY_LIMIT 的值) memory: ${MEMORY_LIMIT} # 环境变量配置 environment: # 启用管理员令牌 ADMIN_TOKEN: true # MySQL 数据库连接字符串(格式:mysql://用户名:密码@主机:端口/数据库名) # 这里按照格式填写之前创建的数据库连接信息 DATABASE_URL: "mysql://vaultwarden:passwo@1Panel-mysql-OeCW:3306/vaultwarden" # 使用官方最新版镜像 image: vaultwarden/server:latest # 容器标签(用于元数据管理) labels: createdBy: Apps # 标识创建者 # 连接到的网络 networks: - 1panel-network # 使用预定义的 1panel-network # 端口映射(格式:主机IP:主机端口:容器端口) ports: - ${HOST_IP}:${PANEL_APP_PORT_HTTP}:80 # 将主机端口映射到容器 80 端口 # 重启策略:始终自动重启 restart: always # 数据卷映射 volumes: # 将宿主机 /opt/vaultwarden 目录挂载到容器 /data 目录 - /opt/vaultwarden:/data四.启动Bitward并配置自动备份以上步骤全完成后就可以尝试启动Bitwarden服务了,这时候把第二部分第三步创建的网站的域名解析到服务器上,后打开域名应该就可以访问vaultwarden了(如果不行请检查是否配置正确)这时候回到1panel管理面板页面开始配置自动备份

通过1panel使用docker部署bitwarden并配置mysql数据库和CDN加速以及自动化备份教程 在此之前你需要准备:聪明的脑子,灵活的手 ,友善的嘴巴,认真的耳朵。废话不多说我们开始吧!一、环境准备与1Panel安装1.服务要求推荐系统:Ubuntu/debian(务必使用最新的系统,不建议使用Centos)硬件配置:1核CPU以上、2GB内存、20GB存储(支持轻量级MySQL运行)域名:需要自己的独立域名,可选是否备案(用于HTTPS证书申请和CDN加速)2.开始搭建首先通过你能想象到的一切方法打开你购买的服务器ssh终端连接然后输入以下命令Ubtnuncurl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sudo bash quick_start.shDebiancurl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && bash quick_start.sh一路回车最后记录下ssh终端打印的1panel信息(外网/内网连接地址,用户名和密码),浏览器打开服务器的1panel网页管理地址登录到1panel管理面板后恭喜你已经完成了第一小步子 xhj016二.部署bitwarden前的准备1.登入1panel后找到侧边栏选择应用商店并打开选择安装如下软件1)mysql(数据库,最新版本即可)2)OpenResty(web平台,用于反向代理bitwarden到外网)这两个软件直接点击搜索然后一键安装即可2.创建一个mysql数据库点开1panel侧边栏的数据库按钮跳转的数据库页面后请按照如下配置创建数据库: 数据库名称(自定义) 数据库用户名(自定义) 数据库密码(自定义,建议使用复杂密码) 权限(所有人%)确定配置后点击确认即可3.创建一个网站用于反向代理bitwarden服务点开1panel侧边栏的网站按钮>网站选项跳转网站管理页面后请按照如下配置创建反向代理网站网站类型(反向代理) 分组(默认) 主域名(你为bitwarden准备的专用域名) 其他域名(默认不写) 监听IPV6(可选可不选) 代号(同网站目录地址,默认即可) 代理地址(填写bitwarden服务地址端口,本篇教程为http://127.0.0.1:8080)三.开始部署bitwarden1.打开1panel的应用商店搜索Bitwarden2.点击安装(请按照如下要求配置)名称(随意,推荐使用Bitwarden,BitwardenServer,Vaultwarden,VaultwardenServer等名字) 版本(默认即可,后续会通过自定义 compose修改安装版本) 端口(这里使用8080) 高级设置(这里要开启) 容器名字(与第一个配置“名称”一样即可) 端口外部访问(这里不要开) CPU限制(默认即可) 内存限制(默认即可) 编辑 compose文件(这里要开启) 拉取镜像(开启)3.自定义 compose配置networks: 1panel-network: external: true # 定义服务列表 services: # 服务名称:vaultwarden(Bitwarden 密码管理器的 Rust 实现) vaultwarden: # 指定容器名称(使用环境变量 CONTAINER_NAME 的值) container_name: ${CONTAINER_NAME} # 部署配置(通常用于 Docker Swarm,但单机模式也可识别) deploy: # 资源限制配置 resources: limits: # 限制 CPU 核数(使用环境变量 CPUS 的值) cpus: ${CPUS} # 限制内存使用量(使用环境变量 MEMORY_LIMIT 的值) memory: ${MEMORY_LIMIT} # 环境变量配置 environment: # 启用管理员令牌 ADMIN_TOKEN: true # MySQL 数据库连接字符串(格式:mysql://用户名:密码@主机:端口/数据库名) # 这里按照格式填写之前创建的数据库连接信息 DATABASE_URL: "mysql://vaultwarden:passwo@1Panel-mysql-OeCW:3306/vaultwarden" # 使用官方最新版镜像 image: vaultwarden/server:latest # 容器标签(用于元数据管理) labels: createdBy: Apps # 标识创建者 # 连接到的网络 networks: - 1panel-network # 使用预定义的 1panel-network # 端口映射(格式:主机IP:主机端口:容器端口) ports: - ${HOST_IP}:${PANEL_APP_PORT_HTTP}:80 # 将主机端口映射到容器 80 端口 # 重启策略:始终自动重启 restart: always # 数据卷映射 volumes: # 将宿主机 /opt/vaultwarden 目录挂载到容器 /data 目录 - /opt/vaultwarden:/data四.启动Bitward并配置自动备份以上步骤全完成后就可以尝试启动Bitwarden服务了,这时候把第二部分第三步创建的网站的域名解析到服务器上,后打开域名应该就可以访问vaultwarden了(如果不行请检查是否配置正确)这时候回到1panel管理面板页面开始配置自动备份 -

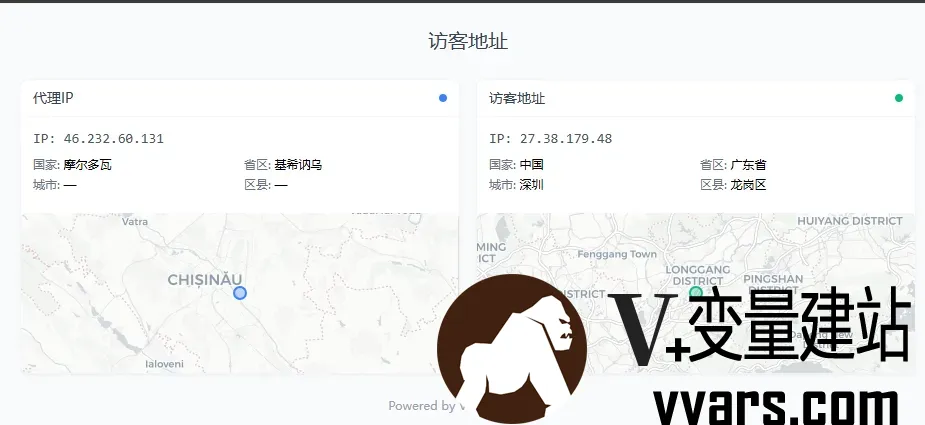

给自己网站增加一个定位插件——调用美团API定位到访者的IP地址 1 前言美团通过IP地址可以快速定位,利用美团API可以给网站增加一个定位到访者的插件。美团API地址为:https://apimobile.meituan.com/locate/v2/ip/loc?rgeo=true&ip=。本文介绍如何调用美团API定位到访者的IP地址,给自己网站增加一个定位插件。2 部署教程2.1 新建ip.php文件在网站目录下新建ip.php文件,如可以选择在子目录tools下新建ip.php文件,其代码如下:<?php if ($_SERVER['REQUEST_METHOD'] === 'POST' && isset($_POST['ip'])) { $ip = $_POST['ip']; $ipData = json_decode(file_get_contents("https://apimobile.meituan.com/locate/v2/ip/loc?rgeo=true&ip=" . urlencode($ip)), true); if (!$ipData || !isset($ipData['data']['lat'])) exit(json_encode(['success' => false])); $lat = $ipData['data']['lat']; $lng = $ipData['data']['lng']; $rgeo = $ipData['data']['rgeo']; $cityData = json_decode(file_get_contents("https://apimobile.meituan.com/group/v1/city/latlng/{$lat},{$lng}?tag=0"), true)['data'] ?? []; exit(json_encode(['success' => true, 'ip' => $ip, 'lat' => $lat, 'lng' => $lng, 'country' => $rgeo['country'] ?? '', 'province' => $rgeo['province'] ?? '', 'city' => $rgeo['city'] ?? '', 'district' => $rgeo['district'] ?? '', 'detail' => $cityData['detail'] ?? ''])); } ?> <!DOCTYPE html> <html lang="zh-CN"> <head> <meta charset="UTF-8"><title>IP Locator</title><meta name="viewport" content="width=device-width,initial-scale=1"> <script src="https://cdn.tailwindcss.com"></script> <link href="https://fastly.jsdelivr.net/npm/[email protected]/dist/leaflet.min.css" rel="stylesheet"/> <script src="https://fastly.jsdelivr.net/npm/[email protected]/dist/leaflet.min.js"></script> </head> <body class="bg-slate-50 font-sans p-3 md:p-6"> <div class="max-w-4xl mx-auto"> <h1 class="text-xl font-medium mb-6 text-center text-gray-700">访客地址</h1> <div class="grid md:grid-cols-2 gap-4" id="cards"></div> <div class="text-center text-xs text-gray-400 mt-6">Powered by <a href="https://www.Vvars.com">V+变量建站日记</a></div> </div> <script> (async () => { const sources = [ {id: 'f', url: 'https://ipv4.lvhai.org/', label: '代理IP', color: '#3b82f6'}, {id: 'd', url: 'https://ipv4_cu.itdog.cn/', label: '访客地址', color: '#10b981'} ]; // Create cards & fetch IPs sources.forEach(s => { document.getElementById('cards').innerHTML += ` <div class="bg-white rounded-lg shadow-sm border border-gray-100 overflow-hidden"> <div class="px-3 py-2 border-b border-gray-100 flex items-center justify-between"> <h2 class="text-sm font-medium text-gray-700">${s.label}</h2> <div class="h-2 w-2 rounded-full" style="background:${s.color}"></div> </div> <div id="${s.id}-content" class="p-3 text-sm"> <div class="animate-pulse h-4 w-20 bg-gray-200 rounded"></div> </div> <div id="${s.id}-map" class="h-40 rounded-md mt-2 hidden"></div> </div>`; // Process IP (async () => { try { // Get IP const ip = await fetch(s.url).then(r => s.url.includes('lvhai') ? r.text().then(t => { try { return JSON.parse(t).ip || t.trim(); } catch { return t.trim(); } }) : r.json().then(j => j.ip)).catch(() => null); if (!ip) { document.getElementById(`${s.id}-content`).innerHTML = `<div class="text-red-500">Failed to get IP</div>`; return; } document.getElementById(`${s.id}-content`).innerHTML = `<div class="font-mono text-gray-600">IP: ${ip}</div>`; // Get location const data = await fetch(location.href, { method: 'POST', headers: {'Content-Type': 'application/x-www-form-urlencoded'}, body: `ip=${encodeURIComponent(ip)}` }).then(r => r.json()); if (!data.success) { document.getElementById(`${s.id}-content`).innerHTML += `<div class="text-red-500 text-xs mt-1">Location failed</div>`; return; } // Update content document.getElementById(`${s.id}-content`).innerHTML = ` <div class="font-mono text-gray-600">IP: ${ip}</div> <div class="grid grid-cols-2 gap-x-2 gap-y-1 text-xs mt-2"> <div><span class="text-gray-500">国家:</span> ${data.country||'—'}</div> <div><span class="text-gray-500">省区:</span> ${data.province||'—'}</div> <div><span class="text-gray-500">城市:</span> ${data.city||'—'}</div> <div><span class="text-gray-500">区县:</span> ${data.district||'—'}</div> </div>`; // Show map with CARTO basemap const mapEl = document.getElementById(`${s.id}-map`); mapEl.classList.remove('hidden'); const map = L.map(mapEl, {zoomControl: false, attributionControl: false}).setView([data.lat, data.lng], 10); L.tileLayer('https://{s}.basemaps.cartocdn.com/light_all/{z}/{x}/{y}{r}.png', { subdomains: 'abcd' }).addTo(map); L.circleMarker([data.lat, data.lng], {radius: 6, color: s.color, weight: 2, fillOpacity: 0.3}).addTo(map); setTimeout(() => map.invalidateSize(), 100); } catch (err) { document.getElementById(`${s.id}-content`).innerHTML = `<div class="text-red-500">Error: ${err.message}</div>`; } })(); }); })(); </script> </body> </html>2.2 在网站模板中加入调用代码可以采用iframe调用,示例代码如下:<iframe frameborder=0 src="https://www.vvars.com/tools/ip.php" style="border-radius:8px; height: 300px; transform: scale(0.85); transform-origin: top left;"></iframe>代码参考,需要自行调整height和scale数值。3 最终效果IP显示:https://www.vvars.com/tools/ip.php网站调用显示:https://www.vvars.com/Website-construction/Add-a-location-plug-in-to-your-website---call-Meituan-API-to-locate-the-visitor-s-IP-address.html

给自己网站增加一个定位插件——调用美团API定位到访者的IP地址 1 前言美团通过IP地址可以快速定位,利用美团API可以给网站增加一个定位到访者的插件。美团API地址为:https://apimobile.meituan.com/locate/v2/ip/loc?rgeo=true&ip=。本文介绍如何调用美团API定位到访者的IP地址,给自己网站增加一个定位插件。2 部署教程2.1 新建ip.php文件在网站目录下新建ip.php文件,如可以选择在子目录tools下新建ip.php文件,其代码如下:<?php if ($_SERVER['REQUEST_METHOD'] === 'POST' && isset($_POST['ip'])) { $ip = $_POST['ip']; $ipData = json_decode(file_get_contents("https://apimobile.meituan.com/locate/v2/ip/loc?rgeo=true&ip=" . urlencode($ip)), true); if (!$ipData || !isset($ipData['data']['lat'])) exit(json_encode(['success' => false])); $lat = $ipData['data']['lat']; $lng = $ipData['data']['lng']; $rgeo = $ipData['data']['rgeo']; $cityData = json_decode(file_get_contents("https://apimobile.meituan.com/group/v1/city/latlng/{$lat},{$lng}?tag=0"), true)['data'] ?? []; exit(json_encode(['success' => true, 'ip' => $ip, 'lat' => $lat, 'lng' => $lng, 'country' => $rgeo['country'] ?? '', 'province' => $rgeo['province'] ?? '', 'city' => $rgeo['city'] ?? '', 'district' => $rgeo['district'] ?? '', 'detail' => $cityData['detail'] ?? ''])); } ?> <!DOCTYPE html> <html lang="zh-CN"> <head> <meta charset="UTF-8"><title>IP Locator</title><meta name="viewport" content="width=device-width,initial-scale=1"> <script src="https://cdn.tailwindcss.com"></script> <link href="https://fastly.jsdelivr.net/npm/[email protected]/dist/leaflet.min.css" rel="stylesheet"/> <script src="https://fastly.jsdelivr.net/npm/[email protected]/dist/leaflet.min.js"></script> </head> <body class="bg-slate-50 font-sans p-3 md:p-6"> <div class="max-w-4xl mx-auto"> <h1 class="text-xl font-medium mb-6 text-center text-gray-700">访客地址</h1> <div class="grid md:grid-cols-2 gap-4" id="cards"></div> <div class="text-center text-xs text-gray-400 mt-6">Powered by <a href="https://www.Vvars.com">V+变量建站日记</a></div> </div> <script> (async () => { const sources = [ {id: 'f', url: 'https://ipv4.lvhai.org/', label: '代理IP', color: '#3b82f6'}, {id: 'd', url: 'https://ipv4_cu.itdog.cn/', label: '访客地址', color: '#10b981'} ]; // Create cards & fetch IPs sources.forEach(s => { document.getElementById('cards').innerHTML += ` <div class="bg-white rounded-lg shadow-sm border border-gray-100 overflow-hidden"> <div class="px-3 py-2 border-b border-gray-100 flex items-center justify-between"> <h2 class="text-sm font-medium text-gray-700">${s.label}</h2> <div class="h-2 w-2 rounded-full" style="background:${s.color}"></div> </div> <div id="${s.id}-content" class="p-3 text-sm"> <div class="animate-pulse h-4 w-20 bg-gray-200 rounded"></div> </div> <div id="${s.id}-map" class="h-40 rounded-md mt-2 hidden"></div> </div>`; // Process IP (async () => { try { // Get IP const ip = await fetch(s.url).then(r => s.url.includes('lvhai') ? r.text().then(t => { try { return JSON.parse(t).ip || t.trim(); } catch { return t.trim(); } }) : r.json().then(j => j.ip)).catch(() => null); if (!ip) { document.getElementById(`${s.id}-content`).innerHTML = `<div class="text-red-500">Failed to get IP</div>`; return; } document.getElementById(`${s.id}-content`).innerHTML = `<div class="font-mono text-gray-600">IP: ${ip}</div>`; // Get location const data = await fetch(location.href, { method: 'POST', headers: {'Content-Type': 'application/x-www-form-urlencoded'}, body: `ip=${encodeURIComponent(ip)}` }).then(r => r.json()); if (!data.success) { document.getElementById(`${s.id}-content`).innerHTML += `<div class="text-red-500 text-xs mt-1">Location failed</div>`; return; } // Update content document.getElementById(`${s.id}-content`).innerHTML = ` <div class="font-mono text-gray-600">IP: ${ip}</div> <div class="grid grid-cols-2 gap-x-2 gap-y-1 text-xs mt-2"> <div><span class="text-gray-500">国家:</span> ${data.country||'—'}</div> <div><span class="text-gray-500">省区:</span> ${data.province||'—'}</div> <div><span class="text-gray-500">城市:</span> ${data.city||'—'}</div> <div><span class="text-gray-500">区县:</span> ${data.district||'—'}</div> </div>`; // Show map with CARTO basemap const mapEl = document.getElementById(`${s.id}-map`); mapEl.classList.remove('hidden'); const map = L.map(mapEl, {zoomControl: false, attributionControl: false}).setView([data.lat, data.lng], 10); L.tileLayer('https://{s}.basemaps.cartocdn.com/light_all/{z}/{x}/{y}{r}.png', { subdomains: 'abcd' }).addTo(map); L.circleMarker([data.lat, data.lng], {radius: 6, color: s.color, weight: 2, fillOpacity: 0.3}).addTo(map); setTimeout(() => map.invalidateSize(), 100); } catch (err) { document.getElementById(`${s.id}-content`).innerHTML = `<div class="text-red-500">Error: ${err.message}</div>`; } })(); }); })(); </script> </body> </html>2.2 在网站模板中加入调用代码可以采用iframe调用,示例代码如下:<iframe frameborder=0 src="https://www.vvars.com/tools/ip.php" style="border-radius:8px; height: 300px; transform: scale(0.85); transform-origin: top left;"></iframe>代码参考,需要自行调整height和scale数值。3 最终效果IP显示:https://www.vvars.com/tools/ip.php网站调用显示:https://www.vvars.com/Website-construction/Add-a-location-plug-in-to-your-website---call-Meituan-API-to-locate-the-visitor-s-IP-address.html -

来自Ns的端口流量限制脚本——Rent-PL ~出租流量的另一种选择 1 前言原帖来自Nodeseek的BlackSheep大佬。Rent-PL是一个端口流量限制脚本,对用户指定的端口组进行流量的统计、限制与周期性重置1.1功能特点基于iptables及cron实现了端口流量统计、流量超限拦截和流量定期重置三大核心功能高可用性,支持TCP+UDP、IPv4+IPv6低破坏性,不会改动已有的iptables规则及cron任务高灵活性,支持添加多组端口/端口范围/两者的组合简易WEB服务,查询流量无需登录机器统计指定sports+出站及指定dports+入站的流量——用于转发、代理类用途时,可视为单向流量1.2项目地址GitHub:https://github.com/BlackSheep-cry/Rent-PLRaw链接:https://raw.githubusercontent.com/BlackSheep-cry/Rent-PL/main/rent.sh2 快速使用以下以Debian/Ubuntu系统为示例2.1安装依赖sudo apt update && sudo apt upgrade sudo apt install iptables bc python3 wget nano openssl其他部分发行版可能还需手动安装cron (cronie/dcron)2.2下载并启动脚本wget -q https://raw.githubusercontent.com/BlackSheep-cry/Rent-PL/main/rent.sh -O /usr/local/bin/rent.sh && chmod +x /usr/local/bin/rent.sh && rent.sh set2.3端口配置模板配置格式:单端口/端口范围/两者的自由组合 月度流量限制(GiB) 重置日期(1-28日) 例如 : 6020-6030 100.00 1 443,80 1.5 15 5201,5202-5205 1 20 7020-7030,7090-7095,7096-8000 10 12PS: 组合端口时请用英文逗号隔开,端口 流量 日期三个参数中间用空格隔开2.4交互模式sudo rent.sh2.5命令行模式sudo rent.sh 命令选项 其他3 Nginx配置WEB服务中如果选择模式1则需要自行在本地配置Nginx/Caddy等作为前置,楼主在这里为不熟悉的朋友提供一个简单的Nginx配置教程3.1安装Nginxapt install nginx3.2修改配置文件nano /etc/nginx/sites-available/rent.conf3.3配置模板(默认443端口,http重写至https)server_tokens off; client_max_body_size 1m; server { listen 443 ssl http2; # 标准HTTPS端口 server_name your.domain; # 修改为您的域名 ssl_certificate /etc/nginx/ssl/rent.crt; # 修改为您的证书路径 ssl_certificate_key /etc/nginx/ssl/rent.key; # 修改为您的私钥路径 ssl_protocols TLSv1.2 TLSv1.3; ssl_prefer_server_ciphers on; ssl_ciphers ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-ECDSA-CHACHA20-POLY1305:ECDHE-RSA-CHACHA20-POLY1305:ECDHE-ECDSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-GCM-SHA384; ssl_ecdh_curve secp384r1:X25519; ssl_session_timeout 10m; ssl_session_cache shared:SSL:10m; ssl_session_tickets off; ssl_stapling on; ssl_stapling_verify on; resolver 8.8.8.8 1.1.1.1 valid=300s; resolver_timeout 5s; add_header Strict-Transport-Security "max-age=63072000; includeSubDomains; preload"; add_header X-Content-Type-Options "nosniff"; add_header X-Frame-Options "SAMEORIGIN"; add_header X-XSS-Protection "0"; add_header Content-Security-Policy "default-src 'self'; script-src 'self' 'unsafe-inline'; style-src 'self' 'unsafe-inline'; img-src 'self' data:; report-uri /csp-report;"; add_header Referrer-Policy "strict-origin-when-cross-origin"; location / { limit_except GET HEAD { deny all; } proxy_pass http://localhost:8080; # 修改为您的WEB端口 proxy_http_version 1.1; proxy_set_header Connection ""; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; proxy_buffering off; proxy_request_buffering off; proxy_connect_timeout 10s; proxy_send_timeout 15s; proxy_read_timeout 30s; } location ~* ^/(\.git|config|backup) { deny all; return 403; } } # HTTP重写至HTTPS server { listen 80; server_name your.domain; # 修改为您的域名 return 301 https://$host$request_uri; }3.4启用站点ln -s /etc/nginx/sites-available/rent.conf /etc/nginx/sites-enabled/3.5重载Nginx,配置完毕nginx -s reload3.6禁用站点rm /etc/nginx/sites-enabled/rent.conf4使用截图5注意事项1)问题反馈:主日志在/var/log/rent.log,WEB日志在/tmp/web_service.log2)如果你使用iptables进行流量转发,请将落地机和中转机端口保持一致,否则脚本无法正常统计流量3)status命令显示的月度限制发生变化是预期行为,而WEB中不会发生变化4)如果你设置的端口在动态端口范围内(可用查询),请确保端口有服务在监听,否则有小概率多统计流量PS:修改动态端口范围也可以,但不太建议:,写入新范围——不能太小,否则高并发下端口会耗尽,最后应用即可sysctl net.ipv4.ip_local_port_range sudo nano /etc/sysctl.conf net.ipv4.ip_local_port_range = xxxxx xxxxx sysctl -p

来自Ns的端口流量限制脚本——Rent-PL ~出租流量的另一种选择 1 前言原帖来自Nodeseek的BlackSheep大佬。Rent-PL是一个端口流量限制脚本,对用户指定的端口组进行流量的统计、限制与周期性重置1.1功能特点基于iptables及cron实现了端口流量统计、流量超限拦截和流量定期重置三大核心功能高可用性,支持TCP+UDP、IPv4+IPv6低破坏性,不会改动已有的iptables规则及cron任务高灵活性,支持添加多组端口/端口范围/两者的组合简易WEB服务,查询流量无需登录机器统计指定sports+出站及指定dports+入站的流量——用于转发、代理类用途时,可视为单向流量1.2项目地址GitHub:https://github.com/BlackSheep-cry/Rent-PLRaw链接:https://raw.githubusercontent.com/BlackSheep-cry/Rent-PL/main/rent.sh2 快速使用以下以Debian/Ubuntu系统为示例2.1安装依赖sudo apt update && sudo apt upgrade sudo apt install iptables bc python3 wget nano openssl其他部分发行版可能还需手动安装cron (cronie/dcron)2.2下载并启动脚本wget -q https://raw.githubusercontent.com/BlackSheep-cry/Rent-PL/main/rent.sh -O /usr/local/bin/rent.sh && chmod +x /usr/local/bin/rent.sh && rent.sh set2.3端口配置模板配置格式:单端口/端口范围/两者的自由组合 月度流量限制(GiB) 重置日期(1-28日) 例如 : 6020-6030 100.00 1 443,80 1.5 15 5201,5202-5205 1 20 7020-7030,7090-7095,7096-8000 10 12PS: 组合端口时请用英文逗号隔开,端口 流量 日期三个参数中间用空格隔开2.4交互模式sudo rent.sh2.5命令行模式sudo rent.sh 命令选项 其他3 Nginx配置WEB服务中如果选择模式1则需要自行在本地配置Nginx/Caddy等作为前置,楼主在这里为不熟悉的朋友提供一个简单的Nginx配置教程3.1安装Nginxapt install nginx3.2修改配置文件nano /etc/nginx/sites-available/rent.conf3.3配置模板(默认443端口,http重写至https)server_tokens off; client_max_body_size 1m; server { listen 443 ssl http2; # 标准HTTPS端口 server_name your.domain; # 修改为您的域名 ssl_certificate /etc/nginx/ssl/rent.crt; # 修改为您的证书路径 ssl_certificate_key /etc/nginx/ssl/rent.key; # 修改为您的私钥路径 ssl_protocols TLSv1.2 TLSv1.3; ssl_prefer_server_ciphers on; ssl_ciphers ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-ECDSA-CHACHA20-POLY1305:ECDHE-RSA-CHACHA20-POLY1305:ECDHE-ECDSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-GCM-SHA384; ssl_ecdh_curve secp384r1:X25519; ssl_session_timeout 10m; ssl_session_cache shared:SSL:10m; ssl_session_tickets off; ssl_stapling on; ssl_stapling_verify on; resolver 8.8.8.8 1.1.1.1 valid=300s; resolver_timeout 5s; add_header Strict-Transport-Security "max-age=63072000; includeSubDomains; preload"; add_header X-Content-Type-Options "nosniff"; add_header X-Frame-Options "SAMEORIGIN"; add_header X-XSS-Protection "0"; add_header Content-Security-Policy "default-src 'self'; script-src 'self' 'unsafe-inline'; style-src 'self' 'unsafe-inline'; img-src 'self' data:; report-uri /csp-report;"; add_header Referrer-Policy "strict-origin-when-cross-origin"; location / { limit_except GET HEAD { deny all; } proxy_pass http://localhost:8080; # 修改为您的WEB端口 proxy_http_version 1.1; proxy_set_header Connection ""; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; proxy_buffering off; proxy_request_buffering off; proxy_connect_timeout 10s; proxy_send_timeout 15s; proxy_read_timeout 30s; } location ~* ^/(\.git|config|backup) { deny all; return 403; } } # HTTP重写至HTTPS server { listen 80; server_name your.domain; # 修改为您的域名 return 301 https://$host$request_uri; }3.4启用站点ln -s /etc/nginx/sites-available/rent.conf /etc/nginx/sites-enabled/3.5重载Nginx,配置完毕nginx -s reload3.6禁用站点rm /etc/nginx/sites-enabled/rent.conf4使用截图5注意事项1)问题反馈:主日志在/var/log/rent.log,WEB日志在/tmp/web_service.log2)如果你使用iptables进行流量转发,请将落地机和中转机端口保持一致,否则脚本无法正常统计流量3)status命令显示的月度限制发生变化是预期行为,而WEB中不会发生变化4)如果你设置的端口在动态端口范围内(可用查询),请确保端口有服务在监听,否则有小概率多统计流量PS:修改动态端口范围也可以,但不太建议:,写入新范围——不能太小,否则高并发下端口会耗尽,最后应用即可sysctl net.ipv4.ip_local_port_range sudo nano /etc/sysctl.conf net.ipv4.ip_local_port_range = xxxxx xxxxx sysctl -p -

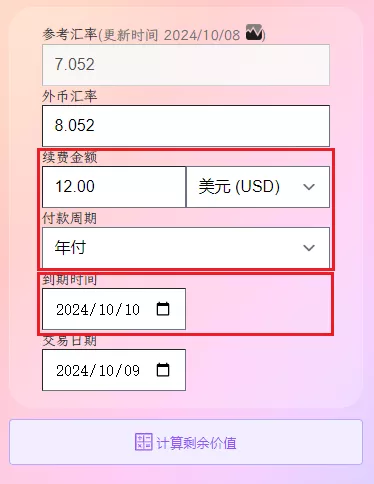

简单实用,打造属于自己的VPS 剩余价值计算器 前言很多时候,站长朋友有些吃灰的VPS不需要了,出售给其他人是个不错的选择,这个时候有个VPS剩余价值计算器是个不错的选择。对一名鸡进鸡出如家常事的 mjj 玩家来说,一枚好用的 VPS 的剩余价值计算器让你在交易中得心应手。而现有的 VPS 剩余价值计算器,使用下来每款总有那么一点点不太符合自己的口味,要么交互一点欠缺,要么功能稍有缺失,或者颜值不足...今天介绍的一款VPS剩余价值计算器来自Nodeseek的semyes大佬,其Github源码地址。🚀项目简介VPS 剩余价值计算器是一个帮助用户精确计算 VPS 产品剩余价值和剩余时间的工具。只需要输入续费金额,选择对应的付款周期、到期时间和交易日期,即可获取 VPS 剩余价值、剩余天数等信息。计算器支持多种支付货币和付款周期,外币汇率每日自动更新,支持自定义汇率计算,并提供一键分享计算结果图片功能。⚡功能特点交互合理简洁清晰的计算结果汇率每日自动更新,并且支持自定义汇率计算更准确的算法,比如大小月非直接取30天计算一键导出计算结果为图片,支持分享适应不同的屏幕,电脑和手机浏览器上体验良好首创 SVG 图片分享,速度更快、体验更佳、流量更省1. 交互合理只需要输入必要的信息,没有其它过多的要求。首先,最基本的信息,续费金额和方式,例如 12.00 美元/年。这个我认为应该是整体的,所以“续费金额”和“货币”得放一行,其次是“付款周期”,告知是“月付”还是“年付”等付款周期,三者一体。其次,到期时间。这个计算剩余多少时间,而决定 VPS 的剩余价值,因此续费金额和周期之后位置。第三,交易时间和外币汇率。两者会影响剩余价值,一般都是计算当天交易,表单默认交易日期为计算当天,外币汇率为当天的汇率。外币汇率有个细节,分固定的参考汇率和可更改的货币汇率,参考汇率是市场决定固定的,货币汇率是交易使用的实际汇率。正常情况,交易汇率直接使用参考汇率,但实际交易中,卖方或者买方可能使用自定义的汇率去计算,这样也是允许的,计算结果需要反映出这一行为。如下图所示,当参考汇率和外币汇率不相等的时候,结果会多自动新增一行,显示使用自定义的外币汇率计算的剩余价值。至于交易货币、交易金额、是否溢价等,我觉得这些都不需要,大而全反而影响使用体验。2. 简洁清晰的计算结果计算之后,需要获取的信息:续费价格及续费周期、剩余天数和过期日期、剩余价值和总价值,没有其它多余无用的信息。其中,当续费货币使用外币的时候,计算结果的总价值展示的是外币转人民币的金额,这点我是很需要的功能。3. 汇率每日自动更新,并且支持自定义汇率计算使用过的要么汇率固定,不会更新,要么有更新但只能使用更新后的汇率,不能自定义,但实际交易卖方或者买方可能使用自定义的汇率去计算,这样也是允许而且很需要的。4. 更准确的算法,比如大小月非直接取30天计算比如,2025/02/10 以 1美元/月购入服务器,下个月 2025/03/10 到期,当天转手,此 VPS 实际交易是 28 天才对,而非 30 天。目前网上的使用过的 VPS 剩余价值,几乎都是使用固定 30 天计算,对于我们这种吹毛求疵的用户,心里总感觉有一个小黑点,不完美了。5. 一键导出计算结果为图片,支持分享计算结果直接保存图片,支持复制 markdown 代码直接分享。6. 适应不同的屏幕,电脑和手机浏览器体验良好电脑和手机屏幕都有良好的用户体验。二📝Docker部署使用1 使用 docker 一键部署(推荐)docker run -d --name=jsq --rm -p=8088:80 hahabye/vps_jsq:latest2 使用 docker-compose 部署# 下载 docker-compose.yml 到本地 wget https://raw.githubusercontent.com/hahabye/vps_jsq/main/docker-compose.yml # 启动服务 docker-compose -f docker-compose.yml up -d三📝Cloudflare部署使用1下载最新的代码:https://github.com/hahabye/vps_jsq/releases/tag/latest2 解压到一个文件夹(只有一个html文件)3 部署Pagescloudflare 左边菜单 选择 Workers 和 Pages,上传文件夹,然后点击部署,完毕.整个过程不足 1 分钟完成一个理论永久在线的 vps 剩余价值计算器四📝自建WEB部署使用前两步与第三步的1、2一样,第3步直接上传到自己VPS可以访问的地址,本站https://www.vvars.com/tools/vps-jsq选择的就是这种部署方式。五 在线演示1 💻在线示例https://www.vvars.com/tools/vps-jsq2 📷运行截图VPS 剩余价值计算器

简单实用,打造属于自己的VPS 剩余价值计算器 前言很多时候,站长朋友有些吃灰的VPS不需要了,出售给其他人是个不错的选择,这个时候有个VPS剩余价值计算器是个不错的选择。对一名鸡进鸡出如家常事的 mjj 玩家来说,一枚好用的 VPS 的剩余价值计算器让你在交易中得心应手。而现有的 VPS 剩余价值计算器,使用下来每款总有那么一点点不太符合自己的口味,要么交互一点欠缺,要么功能稍有缺失,或者颜值不足...今天介绍的一款VPS剩余价值计算器来自Nodeseek的semyes大佬,其Github源码地址。🚀项目简介VPS 剩余价值计算器是一个帮助用户精确计算 VPS 产品剩余价值和剩余时间的工具。只需要输入续费金额,选择对应的付款周期、到期时间和交易日期,即可获取 VPS 剩余价值、剩余天数等信息。计算器支持多种支付货币和付款周期,外币汇率每日自动更新,支持自定义汇率计算,并提供一键分享计算结果图片功能。⚡功能特点交互合理简洁清晰的计算结果汇率每日自动更新,并且支持自定义汇率计算更准确的算法,比如大小月非直接取30天计算一键导出计算结果为图片,支持分享适应不同的屏幕,电脑和手机浏览器上体验良好首创 SVG 图片分享,速度更快、体验更佳、流量更省1. 交互合理只需要输入必要的信息,没有其它过多的要求。首先,最基本的信息,续费金额和方式,例如 12.00 美元/年。这个我认为应该是整体的,所以“续费金额”和“货币”得放一行,其次是“付款周期”,告知是“月付”还是“年付”等付款周期,三者一体。其次,到期时间。这个计算剩余多少时间,而决定 VPS 的剩余价值,因此续费金额和周期之后位置。第三,交易时间和外币汇率。两者会影响剩余价值,一般都是计算当天交易,表单默认交易日期为计算当天,外币汇率为当天的汇率。外币汇率有个细节,分固定的参考汇率和可更改的货币汇率,参考汇率是市场决定固定的,货币汇率是交易使用的实际汇率。正常情况,交易汇率直接使用参考汇率,但实际交易中,卖方或者买方可能使用自定义的汇率去计算,这样也是允许的,计算结果需要反映出这一行为。如下图所示,当参考汇率和外币汇率不相等的时候,结果会多自动新增一行,显示使用自定义的外币汇率计算的剩余价值。至于交易货币、交易金额、是否溢价等,我觉得这些都不需要,大而全反而影响使用体验。2. 简洁清晰的计算结果计算之后,需要获取的信息:续费价格及续费周期、剩余天数和过期日期、剩余价值和总价值,没有其它多余无用的信息。其中,当续费货币使用外币的时候,计算结果的总价值展示的是外币转人民币的金额,这点我是很需要的功能。3. 汇率每日自动更新,并且支持自定义汇率计算使用过的要么汇率固定,不会更新,要么有更新但只能使用更新后的汇率,不能自定义,但实际交易卖方或者买方可能使用自定义的汇率去计算,这样也是允许而且很需要的。4. 更准确的算法,比如大小月非直接取30天计算比如,2025/02/10 以 1美元/月购入服务器,下个月 2025/03/10 到期,当天转手,此 VPS 实际交易是 28 天才对,而非 30 天。目前网上的使用过的 VPS 剩余价值,几乎都是使用固定 30 天计算,对于我们这种吹毛求疵的用户,心里总感觉有一个小黑点,不完美了。5. 一键导出计算结果为图片,支持分享计算结果直接保存图片,支持复制 markdown 代码直接分享。6. 适应不同的屏幕,电脑和手机浏览器体验良好电脑和手机屏幕都有良好的用户体验。二📝Docker部署使用1 使用 docker 一键部署(推荐)docker run -d --name=jsq --rm -p=8088:80 hahabye/vps_jsq:latest2 使用 docker-compose 部署# 下载 docker-compose.yml 到本地 wget https://raw.githubusercontent.com/hahabye/vps_jsq/main/docker-compose.yml # 启动服务 docker-compose -f docker-compose.yml up -d三📝Cloudflare部署使用1下载最新的代码:https://github.com/hahabye/vps_jsq/releases/tag/latest2 解压到一个文件夹(只有一个html文件)3 部署Pagescloudflare 左边菜单 选择 Workers 和 Pages,上传文件夹,然后点击部署,完毕.整个过程不足 1 分钟完成一个理论永久在线的 vps 剩余价值计算器四📝自建WEB部署使用前两步与第三步的1、2一样,第3步直接上传到自己VPS可以访问的地址,本站https://www.vvars.com/tools/vps-jsq选择的就是这种部署方式。五 在线演示1 💻在线示例https://www.vvars.com/tools/vps-jsq2 📷运行截图VPS 剩余价值计算器

![[MV]-林俊杰-裹着心的光——当微光遇见微光,黑暗便有了裂痕](https://www.vvars.com/img/i/2025/06/01/1748775305.webp)

![[MV]-孙燕姿-日落——日落温柔归:孙燕姿一场“退”的勇气](https://www.vvars.com/img/i/2025/05/31/1748659182.webp)

![[MV]-林俊杰-交换余生——当平行时空在琴弦上共振:解码《交换余生》的宿命论美学](https://www.vvars.com/img/i/2025/05/23/1748014615.webp)

![[MV]-林俊杰-可惜没如果——当琴键悬停于半空:重读《可惜没如果》的未完成美学](https://www.vvars.com/img/i/2025/05/23/1748012048.webp)